如何克服算力“焦虑”?这场NVIDIA GTC21 Spring技术回顾硬核解答

作为人工智能行业的技术领袖,NVIDIA面向智慧城市、数据中心、自动驾驶等领域发布并交付了许多具有竞争力和影响力的产品。在今年GTC21 Spring期间,NVIDIA除了发布首款专为巨型AI和HPC负载打造的Arm架构服务器CPU,还有许多值得关注的亮点,6月23日直播为你回顾了GTC21 Spring以下精彩内容:Ampere架构的GPU新产品;智能视频分析应用框架Metropolis;会话式AI应用框架Jarvis。在进行智能视频处理等AI应用的大规模部署时,这些新产品和相应的SDK正在为性能和功耗的平衡提供更多帮助,以打造更高效的系统。

01 Ampere架构的新特性

Ampere架构带来很多新特性,其中,大家比较关心的有3点:第三代Tensor Cores;新颖的结构化稀疏(Structured sparsity);多实例GPU(简称MIG)。第三代Tensor Cores除了吞吐量和上一代相比有明显提升之外,还支持更多数据类型,比如TF32。结构化稀疏的作用则在于把产品算力提升两倍。

1、多实例GPU(MIG)

多实例GPU是一个新的功能,形象的说,就是把一个GPU切成很多份,分给不同用户使用。在此之前,如果要在一个GPU上运行多任务,需要把有限的资源进行时分复用,每一个任务调度一个GPU时间片段,这样带来的问题是,如果一个任务出现bug,那么会导致它所占用的时间片段被无限拉长,引起其他任务的QS无法保证。所以为了解决这个问题,NVIDIA引入MIG,在物理层面把GPU进行切分,每个用户占用相互独立的硬件资源,并且每个用户之间的硬件资源是相互隔离的。比如A100最多可以分为7个小的GPU;A30可分成4个。

2、第三代Tensor Core

第三代Tensor Core除了吞吐量有提升之外,还引入了新的数据类型,最主要是 TF32,即TensorFloat32。数据的表达由不同的位数组成,比如说FP32,是1个符号位,8个的指数位,23个的精度位;FP16是1个符号位,5个的指数位,10个的精度位。早期大家都使用FP32做训练,为了缩短训练时间,可能会使用混合精度训练,即FP32加FP16,之所以使用FP16,因为FP16可以更高效利用Tensor Core做矩阵乘操作。

问题是FP16的值区间并不充足,因为FP32是8个的指数位,FP16是5个的指数位,值区间不足导致计算过程中容易溢出Overflow。此外,存在梯度爆炸的情况。针对这种情况,提出了TF32这种数据结构。

TF32是1个符号位,8个指数位,10个精度位。TF32指数位和FP32相同,都是8位,所以说它的表值区间和FP32相同,同时它又比FP32的比特位数少,所以其计算效率比FP32高。总的来说,TF32是精度范围的表值区间与计算速度的折中。

3、结构化稀疏(Structured sparsity)

借助A100,NVIDIA引入了结构稀疏性,这是一种新颖的方法,可将深度神经网络的计算吞吐量提高一倍。

02 数据中心GPU新产品:A10/A30/A16

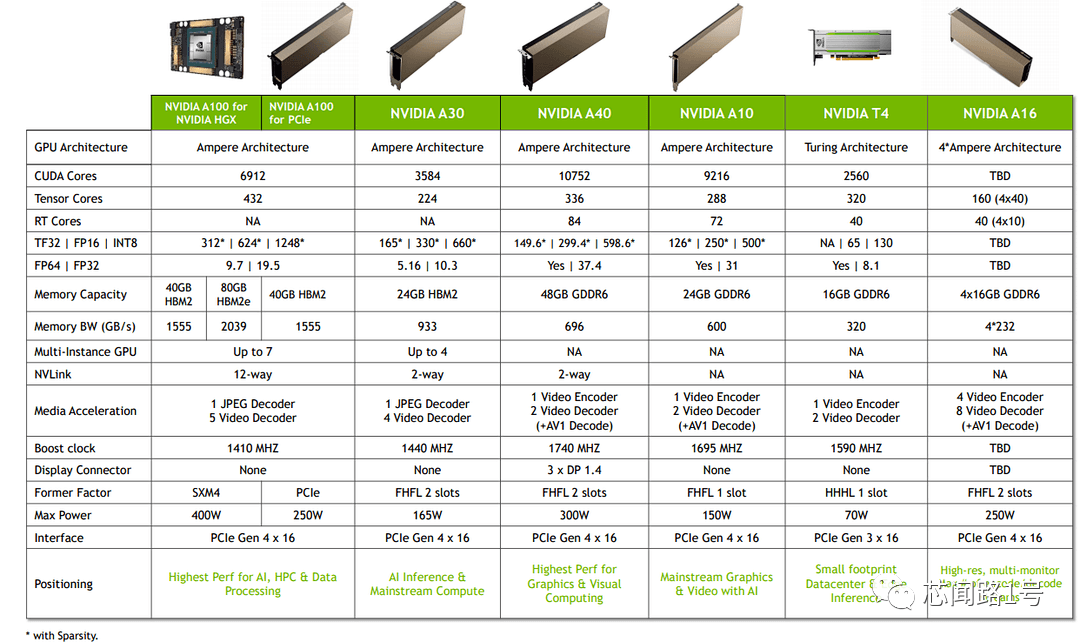

基于Ampere架构的数据中心GPU产品中,目前A100是推理性能最强的一张卡,有PCIe版本和NVLink两个版本。PCIe版本的功耗是250W,NVLink版本功耗是400W,支持7个MIG。今年GTC21发布的新品包括A10、A30和A16。A30是A100的低配版,功能上两者是完全相同的,A30是165W功耗、24G显存,双卡槽位。

在GTC21之前发布的A40针对渲染场景,拥有最快光追RT内核,同时拥有最大的渲染模型,功耗300W、显存48G、双卡槽位。使用大容量显存主要是为了适配大型图形任务的显存要求。新品A10具备优良的视觉计算能力和出众的推理性能,其算力和显存都跟目前主流T4相比有比较大的提升,功耗150W、24G显存、一个槽位。

A16则对Transcoding性能和增大用户密度做了针对性优化,是为了适配例如虚拟桌面的高密度、高并发的场景,这种应用场景需要处理大量视频流,例如,视频分析应用中有大量camera需要使用同一个GPU的时候,A16是个不错的选择。该产品功耗250W、64G显存,包含有4个小GPU芯片,每部分都具有编解码能力,支持高并发编码需求。

可以从几个方面进行产品选型。首先是use case所使用的数据精度,比如说是FP32还是FP16等。根据算力情况与usecase结合选择合适的板卡。或者也可以根据memory size来选择,因为每个卡的显存是不一样的,用户可以结合模型的复杂度、模型大小,以及在做inference的时候,输入的Batch size选择不同显存做板卡选型。如果想在应用中利用MIG特性,可以选择A100或者A30。另外,视频编解码能力、功耗等也是产品选型的要素。

数据中心产品迁移路线:如果之前使用V100,那么建议用户迁移到A100;面向渲染场景的RTX可以迁移到A40;T4其实的迁移选择比较多,如果现在T4运行得比较好,可以继续选择用T4,如果想有一些升级的话,可以升级到A10,A10显存是T4的1.5倍。也可以升级到比较全面的A30;M10建议用户迁移到A16,适用于虚拟桌面以及应对高并发的视频推理场景。

03

Metropolis智能视频分析框架

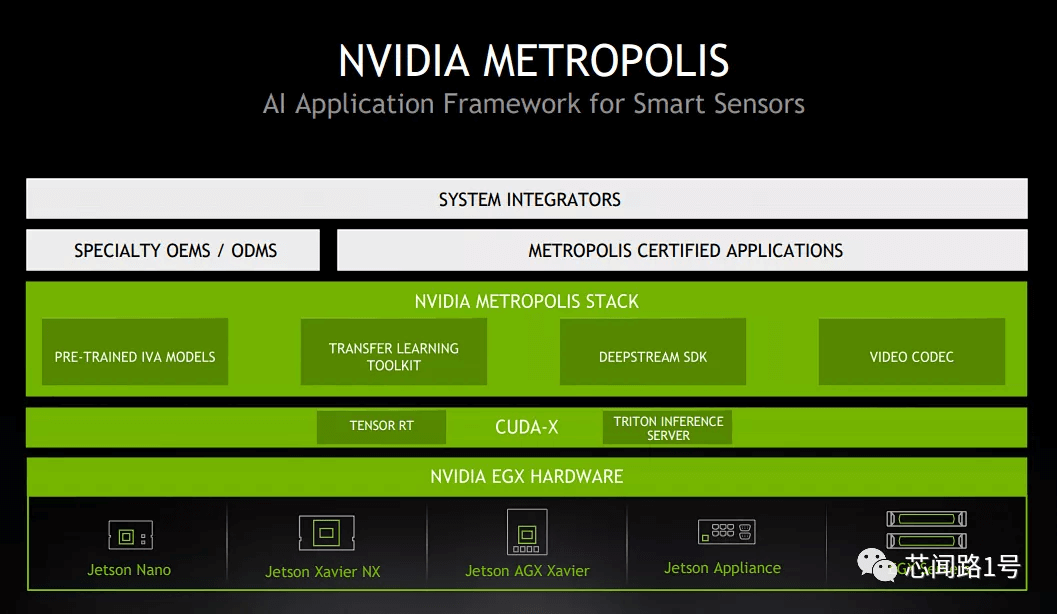

Metropolis智能视频分析框架是NVIDIA众多行业应用框架的之一,这些框架解决GPU通用性问题和行业应用定制化问题。众所周知,GPU加速卡应用在各行各业,可以用来做视频图形渲染;其高速并行计算能力可以用来做人工智能。为了让通用的硬件去解决行业定制化的问题,NVIDIA对每个行业开发出相应的应用框架。

Metropolis是针对视频分析的应用框架,除此之外,NVIDIA还有针对于数据分析的RAPIDS库;针对于自主机器人的ISAAC SDK;针对于会话式AI的JARVIS应用框架。所有这些软件都建立在CUDA、NVIDIA硬件之上。

Metropolis包含多个预训练模型,客户可以结合自己的实际应用场景,使用NVIDIA迁移学习工具包进行迁移学习,获得定制化的算法模型,然后使用Deepstream部署定制模型在智能视频分析应用中,获得能够为客户所用的智能视频服务,这个过程中,所有编解码功能,都可以使用NV CODEC SDK来实现。

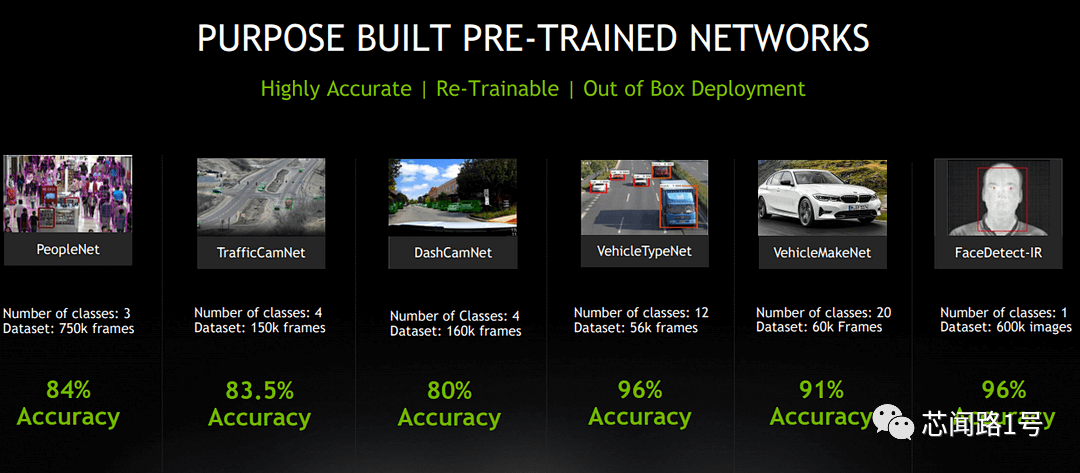

除了通用模型之外,NVIDIA提供场景定制化模型,这些模型是在日常生活中比较常见的,比如说高位抓拍机检测行人的数量;比如说高速路口检测车的类型,判断是客车还是货车;再比如说,识别车的品牌等等,这些其实在市场生活中经常会用到。针对这些稍微定制化一些的场景,NVIDIA提供定制化模型,在模型的结构上做了一些优化,保证模型在inference时候具备高吞吐量,同时结合很多定制化场景的数据对模型精度进行优化。在不同的应用中,基本上能达到80%以上的精确度。

04 Jarvis会话式AI框架

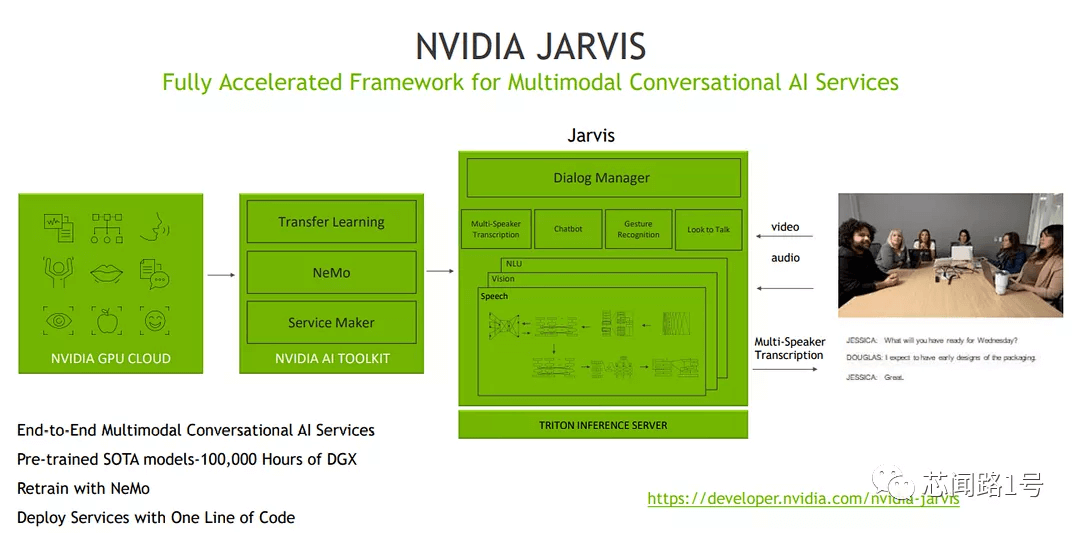

NVIDIA Jarvis框架为开发者提供经过预先训练的深度学习模型和软件工具,以创建可轻松适应每个行业和领域的会话式AI服务。

针对每天会生成数十亿小时的通话、网络会议和流式传输视频内容,NVIDIAJarvis模型可提供高度精确的语音识别、语言理解、多语言实时翻译以及新的语音合成功能,最终可创建会话式AI代理。

借助GPU加速,端到端语音流程运行时间可达到300毫秒内(包括聆听、理解和生成响应都在内的速度,比人眼眨眼还要快),并部署在云端、数据中心或边缘,可立即将规模扩展为数百万用户。

识别二维码 观看完整直播